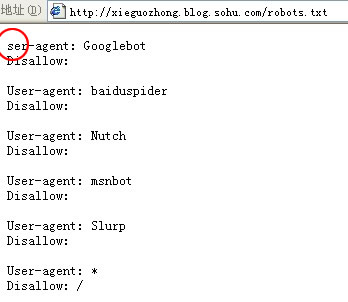

今天在某网站上看到这样一个帖子,由于搜狐博客的robots.txt文件在书写时时犯下一个低级错误,少写一个字母U,导致搜狐博客被google K掉。

试想辛辛苦苦在博客上做的外链,结果就由于程序员马虎大意,导致你的努力付之东流。没有比这更悲催的事情了。于是,大禹写下此文,以提醒站长朋友做外链时,切勿马虎大意,一定警惕以下外链隐形杀手。

杀手一:robots.txt

Robots.txt中disallow的URL将禁止搜索引擎访问,允许索引,显示搜索结果。知名的就是淘宝屏蔽百度蜘蛛。截止发稿,搜狐博客robots.txt文件错误已修改。大禹相继查询了新浪、网易、搜狐、腾讯的博客频道的robots.txt文件,均未发现有屏蔽主流搜索引擎的行为。但大禹还是得提醒SEOer在做外链时,切忌先查询robots.txt文件,以免你的努力付之东流。

杀后二:nofollow

做SEO的对nofollow一定不会陌生,nofollow是标签中rel属性值,其允许访问href属性的值,允许索引,显示结果,但不传递PR值,即不传递权重。今天在站长网上看到有帖子称国内某知名站长论坛对签名链接加了nofollow,经验证,纯属谣言。但可见站长对nofollow的恐慌。不传递权重的外链毫无意义,比较知名的就是网易博客设置了nofollow。

杀手三:js/ajax

这个对于我们做友情链接显得尤其重要。这种js或ajax异步调用的链接毫无意义。但我们站长在做友链时往往疏于防范,仅仅凭肉眼看对方网站上是存在自己的链接。其实,通过专业的友情链接检测工具或检查页面源文件中URL是否被标签包含就能很容易的识别。

杀手四:inframe

这个实际上是另一种变相假链,和js调用如出一辙。区别只是在于这个链接是存在的,但不在对方首页或友情链接页面。识别方法同js假链是一样的。

其实这些文件、标签、或是技术本身并不是为了屏蔽或阻止链接。只是不同的人、不同的目地使其成为了我们外链的隐形杀手,做SEO的要提防。文章原创,转载请注明出处 788中国门窗幕墙人才网 http://www.788job.net,谢谢。

感谢 的投稿